Podstawowa struktura modułu kamery

I. Budowa i zasada działania aparatu

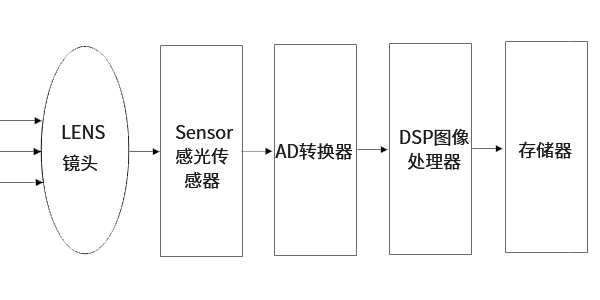

Scena jest kręcona przez obiektyw, wygenerowany obraz optyczny jest rzutowany na czujnik, a następnie obraz optyczny jest przekształcany na sygnał elektryczny, który jest przekształcany na sygnał cyfrowy poprzez konwersję analogowo-cyfrową.Sygnał cyfrowy jest przetwarzany przez DSP, a następnie przesyłany do komputera w celu przetworzenia, a na końcu zamieniany na obraz, który można zobaczyć na ekranie telefonu.

Funkcja układu cyfrowego przetwarzania sygnału (DSP): optymalizuj parametry sygnału cyfrowego obrazu za pomocą szeregu złożonych algorytmów matematycznych i przesyłaj przetworzone sygnały do komputerów PC i innych urządzeń przez USB i inne interfejsy.Rama struktury DSP:

1、 ISP (procesor sygnału obrazu)

1. ISP (procesor sygnału obrazu)

2, koder JPEG

2. Koder JPEG

3, kontroler urządzenia USB

3. Kontroler urządzenia USB

Istnieją dwa rodzaje popularnych czujników kamer,

Jednym z nich jest czujnik CCD (Chagre Couled Device), czyli urządzenie ze sprzężeniem ładunkowym.

Drugi to czujnik CMOS (Complementary Metal-Oxide Semiconductor), czyli komplementarny półprzewodnik z tlenku metalu.

Zaletą CCD jest dobra jakość obrazu, ale proces produkcji jest skomplikowany, koszt jest wysoki, a zużycie energii wysokie.Przy tej samej rozdzielczości CMOS jest tańszy niż CCD, ale jakość obrazu jest niższa niż CCD.W porównaniu z CCD, przetwornik obrazu CMOS ma mniejsze zużycie energii.Ponadto, wraz z postępem technologicznym procesu, jakość obrazu CMOS była stale poprawiana.Dlatego wszystkie obecne na rynku aparaty do telefonów komórkowych wykorzystują czujniki CMOS.

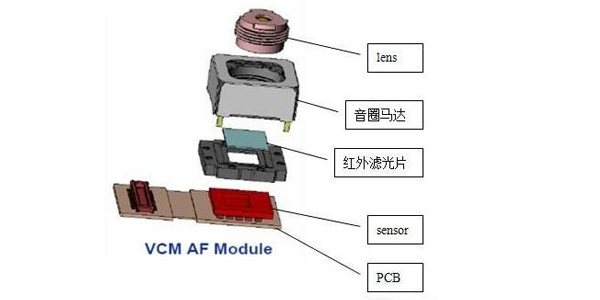

Prosta struktura aparatu w telefonie komórkowym

Soczewka: zbierz światło i rzutuj scenę na powierzchnię nośnika obrazowania.

Czujnik obrazu: nośnik obrazu, który przetwarza obraz (sygnał świetlny) rzutowany przez soczewkę na powierzchnię na sygnał elektryczny.

Silnik: napędza ruch soczewki, dzięki czemu soczewka wyświetla wyraźny obraz na powierzchni nośnika obrazu.

Filtr kolorów: Scena widziana przez ludzkie oko znajduje się w paśmie światła widzialnego, a czujnik obrazu może rozpoznać pasmo światła lepiej niż ludzkie oko.Dlatego dodano filtr kolorów, aby odfiltrować nadmiar pasma światła, dzięki czemu czujnik obrazu może uchwycić rzeczywiste sceny widziane oczami.

Układ napędowy silnika: używany do sterowania ruchem silnika i napędzania obiektywu w celu uzyskania autofokusa.

Podłoże płytki drukowanej: Prześlij sygnał elektryczny czujnika obrazu do tylnego końca.

II.Powiązane parametry i rzeczowniki

1. Popularne formaty obrazów

Format 1.1RGB:

Tradycyjny format czerwony, zielony i niebieski, taki jak RGB565 i RGB888;16-bitowy format danych to 5-bitowy R + 6-bitowy G + 5-bitowy B. G ma jeszcze jeden bit, ponieważ ludzkie oczy są bardziej wrażliwe na kolor zielony.

1.2 Format YUV:

Format Luma (Y) + Chroma (UV).YUV odnosi się do formatu pikseli, w którym parametr luminancji i parametr chrominancji są wyrażone oddzielnie.Zaletą tej separacji jest to, że nie tylko unika się wzajemnych interferencji, ale także zmniejsza częstotliwość próbkowania chrominancji bez zbytniego wpływu na jakość obrazu.YUV to termin bardziej ogólny.Ze względu na swoją specyficzną aranżację można go podzielić na wiele specyficznych formatów.

Chroma (UV) definiuje dwa aspekty koloru: odcień i nasycenie, które są reprezentowane odpowiednio przez CB i CR.Wśród nich Cr odzwierciedla różnicę między czerwoną częścią sygnału wejściowego RGB a wartością jasności sygnału RGB, podczas gdy Cb odzwierciedla różnicę między niebieską częścią sygnału wejściowego RGB a wartością jasności sygnału RGB.

Główne formaty próbkowania to YCbCr 4:2:0, YCbCr 4:2:2, YCbCr 4:1:1 i YCbCr 4:4:4.

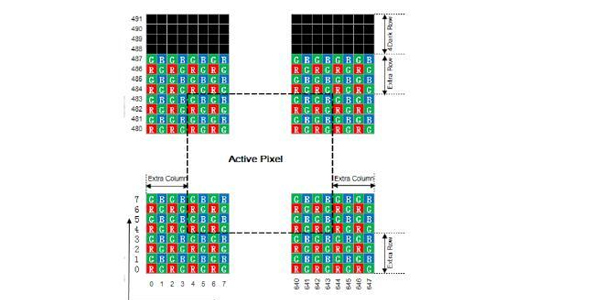

1.3 Format danych RAW:

Obraz RAW to surowe dane, które przetwornik obrazu CMOS lub CCD przetwarza przechwycony sygnał źródła światła na sygnał cyfrowy.Plik RAW to plik, który rejestruje oryginalne informacje o czujniku aparatu cyfrowego i niektóre metadane (takie jak ustawienia ISO, czas otwarcia migawki, wartość przysłony, balans bieli itp.) wygenerowane przez aparat.RAW to nieprzetworzony i nieskompresowany format, który można określić jako „dane zakodowane w surowym obrazie” lub bardziej obrazowo nazywany „cyfrowym negatywem”.Każdy piksel czujnika odpowiada filtrowi kolorów, a filtry są rozmieszczone zgodnie ze wzorem Bayera.Dane każdego piksela są wyprowadzane bezpośrednio, a mianowicie dane RAW RGB

Surowe dane (Raw RGB) stają się RGB po interpolacji kolorów.

Przykład obrazu w formacie RAW

2. Powiązane wskaźniki techniczne

2.1 Rozdzielczość obrazu:

SXGA (1280x1024), 1,3 megapiksela

XGA (1024x768), 0,8 megapiksela

SVGA (800x600), 0,5 megapiksela

VGA (640x480), 0,3 megapiksela (0,35 megapiksela odnosi się do 648X488)

CIF(352x288), 0,1 megapiksela

SIF/QVGA (320x240)

QCIF(176x144)

QSIF/QQVGA(160x120)

2.2 Głębia koloru (liczba bitów koloru):

256 kolorów w skali szarości, 256 rodzajów szarości (w tym czerń i biel).

15 lub 16-bitowy kolor (wysoki kolor): 65 536 kolorów.

Kolor 24-bitowy (true color): Każdy kolor podstawowy ma 256 poziomów, a ich kombinacja ma 256*256*256 kolorów.

Kolor 32-bitowy: oprócz koloru 24-bitowego dodatkowe 8 bitów jest używanych do przechowywania danych graficznych nakładającej się warstwy (kanał alfa).

2.3 Zoom optyczny i zoom cyfrowy:

Zoom optyczny: Powiększ/pomniejsz obiekt, który chcesz sfotografować, regulując obiektyw.Utrzymuje piksele i jakość obrazu w zasadzie niezmienione, ale można zrobić idealne zdjęcie.Zoom cyfrowy: właściwie nie ma zoomu.Po prostu bierze z oryginalnego zdjęcia i powiększa. To, co widzisz na ekranie LCD, jest powiększone, ale jakość obrazu nie ulega znacznej poprawie, a piksele są mniejsze niż maksymalna liczba pikseli, jaką może zarejestrować aparat.Jakość obrazu jest w zasadzie niegodna, ale może zapewnić pewną wygodę.

2.4 Metoda kompresji obrazu:

JPEG/M-JPEG

H.261/H.263

MPEG

H.264

2.5 Zakłócenia obrazu:

Odnosi się do szumu i interferencji w obrazie i pojawia się jako stały szum koloru na obrazie.

2.6 Automatyczny balans bieli:

Mówiąc najprościej: przywracanie białych obiektów przez aparat.Pojęcia pokrewne: temperatura barwowa.

2.7 Kąt widzenia:

Ma tę samą zasadę, co obrazowanie ludzkiego oka, które jest również znane jako zakres obrazowania.

2.8 Automatyczne ustawianie ostrości:

Autofokus można podzielić na dwie kategorie: jeden to autofokus oparty na odległości między obiektywem a obiektem, a drugi to autofokus wykrywający ostrość, oparty na wyraźnym obrazie na matówce (algorytm ostrości).

Uwaga: Powiększanie polega na przybliżaniu odległych obiektów.Skupienie polega na tym, aby obraz był wyraźny.

2.9 Automatyczna ekspozycja i Gamma:

Jest to połączenie przysłony i migawki.Przysłona, czas otwarcia migawki, ISO.Gamma to krzywa odpowiedzi ludzkiego oka na jasność.

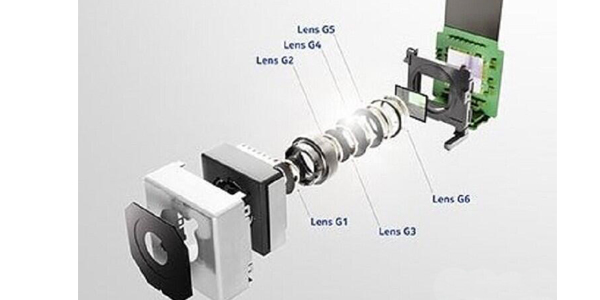

III.Inna konstrukcja aparatu

3.1 Struktura kamery o stałej ogniskowej

3.2 Budowa aparatu z optyczną stabilizacją obrazu

3.3 Aparat MEMS

Czas postu: 28 maja 2021 r